Store 2.0: Unterschied zwischen den Versionen

Admin (Diskussion | Beiträge) |

|||

| (43 dazwischenliegende Versionen von 6 Benutzern werden nicht angezeigt) | |||

| Zeile 50: | Zeile 50: | ||

4.) Mounten: | 4.) Mounten: | ||

mount /dev/mapper/cr_md125 /data | mount /dev/mapper/cr_md125 /data | ||

Wichtig, speziell für data2 mit ext4 und ghost-inodes: | |||

mount -o rw,errors=continue,noatime /dev/mapper/cr_md126 /data2 | |||

Schliessen wäre: | Schliessen wäre: | ||

| Zeile 129: | Zeile 130: | ||

Serial auslesen mit: | Serial auslesen mit: | ||

udevadm info --query=all --name=/dev/sdi | grep ID_SERIAL_SHORT | udevadm info --query=all --name=/dev/sdi | grep ID_SERIAL_SHORT | ||

Für /dev/disk/by-id | |||

udevadm info --query=all --name=/dev/sdi1 | grep disk/by-id/ata | |||

Serial Systemplatte 160GB: | Serial Systemplatte 160GB: | ||

| Zeile 134: | Zeile 137: | ||

== Serials der Datenplatten == | == Serials der Datenplatten == | ||

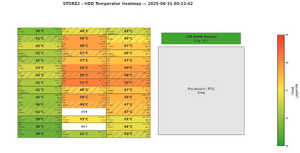

[[Datei:2025-08-31 00-23-42-STORE2-HDD-Heatmap-DE.png|mini|2025-08-31 00-23-42-STORE2-HDD-Heatmap]] | |||

00 : 00000000000000 (1TB System (Arch), Samsung) | 00 : 00000000000000 (1TB System (Arch), Samsung) /dev/disk/by-id/ata-SAMSUNG_HD103UJ_00000000000000 | ||

---- | ---- | ||

geht | geht | ||

01 : 234BGY0GS (3TB Toshiba) data 014 | 01 : 234BGY0GS (3TB Toshiba) data 014 /dev/disk/by-id/ata-TOSHIBA_DT01ABA300_234BGY0GS-part1 | ||

02 : ZDHB5RY6 (3TB Ironwolf NAS) data 016 | 02 : ZDHB5RY6 (3TB Ironwolf NAS) data 016 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHB5RY6-part1 | ||

03 : ZGY7743F (3TB Ironwolf NAS) data 015 | 03 : ZGY7743F (3TB Ironwolf NAS) data 015 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7743F-part1 | ||

04 : MJ1311YNG3Y4SA (3TB Toshiba) data 005 | 04 : MJ1311YNG3Y4SA (3TB Toshiba) data 005 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3Y4SA-part1 | ||

05 : MJ1311YNG3SYKA (3TB Toshiba) data 001 | 05 : MJ1311YNG3SYKA (3TB Toshiba) data 001 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SYKA-part1 | ||

---- | ---- | ||

geht jetzt auch, Molex-Kontakt Problem behoben | geht jetzt auch, Molex-Kontakt Problem behoben | ||

06 : MJ1311YNG4J48A (3TB Toshiba) data2 113 | 06 : MJ1311YNG4J48A (3TB Toshiba) data2 113 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG4J48A-part1 | ||

07 : WW60B6RZ (4TB Seagate Ironwolf Slim) data2 116 | 07 : WW60B6RZ (4TB Seagate Ironwolf Slim) data2 116 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60B6RZ-part1 | ||

08 : WD-WCC4N3CHNN7K (3TB WD Red) data2 114 | 08 : WD-WCC4N3CHNN7K (3TB WD Red) data2 114 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N3CHNN7K-part1 | ||

09 : MJ1311YNG3UUPA (3TB Toshiba) data 012 | 09 : MJ1311YNG3UUPA (3TB Toshiba) data 012 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3UUPA-part1 | ||

10 : MJ0351YNGA02YA (3TB Toshiba) data2 102 | 10 : MJ0351YNGA02YA (3TB Toshiba) data2 102 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ0351YNGA02YA-part1 | ||

---- | ---- | ||

geht | geht | ||

11 : MJ1311YNG3SAMA (3TB) data 013 | 11 : MJ1311YNG3SAMA (3TB) data 013 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SAMA-part1 -> potentiell gefährded, hat 6 Pending Sectors, 13,5 Jahre alt -> evtl. proaktiv tauschen | ||

12 : WW60CK42 (4TB Seagate IronWolf Slim) data2 121 | 12 : WW60CK42 (4TB Seagate IronWolf Slim) data2 121 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CK42-part1 | ||

13 : MJ1311YNG09EDA (3TB) data2 104 | 13 : MJ1311YNG09EDA (3TB) data2 104 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG09EDA-part1 | ||

14 : WD-WCC7K7VCRJZT (3TB WD Red) data 002 | 14 : WD-WCC7K7VCRJZT (3TB WD Red) data 002 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K7VCRJZT-part1 | ||

15 : MCE9215Q0AUYTW (3TB Toshiba) data2 100 | 15 : MCE9215Q0AUYTW (3TB Toshiba) data2 100 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCE9215Q0AUYTW-part1 | ||

---- | ---- | ||

geht | geht | ||

16 : ZDHBBDY5 (4TB Seagate Ironwolf) data2 120 | 16 : ZDHBBDY5 (4TB Seagate Ironwolf) data2 120 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDHBBDY5-part1 | ||

17 : | 17 : | ||

18 : ZGY7821M (3TB Seagate IronWolf) data2 119 | 18 : ZGY7821M (3TB Seagate IronWolf) data2 119 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7821M-part1 | ||

19 : | 19 : | ||

20 : MJ1311YNG3RM5A (3TB Toshiba) data 008 | 20 : MJ1311YNG3RM5A (3TB Toshiba) data 008 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3RM5A-part1 | ||

---- | ---- | ||

geht | geht | ||

21 : WD-WCC7K5THL257 (3TB WD Red) data2 103 | 21 : WD-WCC7K5THL257 (3TB WD Red) data2 103 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K5THL257-part1 | ||

22 : ZDHA9E6A (3TB Seagate Ironwolf) data 018 | 22 : ZDHA9E6A (3TB Seagate Ironwolf) data 018 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHA9E6A-part1 | ||

23 : WD-WMC4N0L7H2HV (3TB WD) data2 107 | 23 : WD-WMC4N0L7H2HV (3TB WD) data2 107 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L7H2HV-part1 | ||

24 : WD-WCC7K2JL6DSL (3TB WD Red) data 010 | 24 : WD-WCC7K2JL6DSL (3TB WD Red) data 010 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K2JL6DSL-part1 | ||

25 : WD-WCC4N5DZ1CEU (3TB WD Red) data2 115 | 25 : WD-WCC4N5DZ1CEU (3TB WD Red) data2 115 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N5DZ1CEU-part1 | ||

---- | ---- | ||

geht | geht | ||

26 : WD-WMC4N0L359DL (3TB WD) data2 106 | 26 : WD-WMC4N0L359DL (3TB WD) data2 106 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L359DL-part1 | ||

27 : WW6078X8 (4TB Seagate IronWolf Slim) data 019 | 27 : WW6078X8 (4TB Seagate IronWolf Slim) data 019 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW6078X8-part1 | ||

28 : WD-WCC4N1ZY6VVY (3TB WD Red) data2 110 | 28 : WD-WCC4N1ZY6VVY (3TB WD Red) data2 110 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N1ZY6VVY-part1 | ||

29 : WD-WCC4N6EVNFZ5 (3TB WD Red) data2 109 | 29 : WD-WCC4N6EVNFZ5 (3TB WD Red) data2 109 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N6EVNFZ5-part1 | ||

30 : WD-WCC4N2DJ9XL8 (3TB WD Red) data 003 | 30 : WD-WCC4N2DJ9XL8 (3TB WD Red) data 003 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2DJ9XL8-part1 | ||

---- | ---- | ||

geht | geht | ||

31 : MJ1311YNG3NT5A (3TB Toshiba) data 009 | 31 : MJ1311YNG3NT5A (3TB Toshiba) data 009 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NT5A-part1 | ||

32 : MCM9215Q0B9LSY (3TB Toshiba) data2 101 | 32 : MCM9215Q0B9LSY (3TB Toshiba) data2 101 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCM9215Q0B9LSY-part1 | ||

33 : ZDHAWE09 (3TB Seagate Ironwolf) data2 105 | 33 : ZDHAWE09 (3TB Seagate Ironwolf) data2 105 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHAWE09-part1 | ||

34 : MJ1311YNG38VGA (3TB Toshiba) data 004 | 34 : MJ1311YNG38VGA (3TB Toshiba) data 004 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG38VGA-part1 | ||

35 : MJ1311YNG3WZVA (3TB Toshiba) data 000 | 35 : MJ1311YNG3WZVA (3TB Toshiba) data 000 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3WZVA-part1 | ||

---- | ---- | ||

geht | geht | ||

36 : WD-WCC7K0SNC8T6 (3TB WD Red) data2 111 | 36 : WD-WCC7K0SNC8T6 (3TB WD Red) data2 111 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K0SNC8T6-part1 | ||

37 : ZDH906SD (4TB Seagate Ironwolf) data2 118 | 37 : ZDH906SD (4TB Seagate Ironwolf) data2 118 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDH906SD-part1 | ||

38 : WD-WCC4N0RC60LS (3TB WD Red) data 006 | 38 : WD-WCC4N0RC60LS (3TB WD Red) data 006 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N0RC60LS-part1 | ||

39 : WD-WCC4N2JPEN1D (3TB WD Red) data 017 | 39 : WD-WCC4N2JPEN1D (3TB WD Red) data 017 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2JPEN1D-part1 | ||

40 : WD-WCC4N4NHKFN0 (3TB WD Red) data2 117 | 40 : WD-WCC4N4NHKFN0 (3TB WD Red) data2 117 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N4NHKFN0-part1 | ||

---- | ---- | ||

geht | geht | ||

41 : WD-WCC4N7CXVHLU (3TB WD Red) data2 112 | 41 : WD-WCC4N7CXVHLU (3TB WD Red) data2 112 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N7CXVHLU-part1 | ||

42 : WW60CTY3 (4TB Seagate IronWolf Slim) data2 122 | 42 : WW60CTY3 (4TB Seagate IronWolf Slim) data2 122 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CTY3-part1 | ||

43 : | 43 : ZW633NRC (4TB IronWolf Slim) data2 108 /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW633NRC-part1 | ||

44 : MJ1311YNG3NZ3A (3TB Toshiba) data 011 | 44 : MJ1311YNG3NZ3A (3TB Toshiba) data 011 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NZ3A-part1 | ||

45 : | 45 : ZW60FC09 (4TB Seagate IronWolf Slim) data 007 /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW60FC09-part1 | ||

TOTAL: 44 (20 + 23 + 0 SPARE (extern aber vorbereitet und getestet) + 1 Systemplatte) von 46 möglichen | TOTAL: 44 (20 + 23 + 0 SPARE (extern aber vorbereitet und getestet) + 1 Systemplatte) von 46 möglichen | ||

== Mapping der Festplatte mit fixer Zuordnung statt sdx == | |||

https://superuser.com/questions/617192/mapping-ata-device-number-to-logical-device-name | |||

= Raid Baubefehl = | = Raid Baubefehl = | ||

| Zeile 1.859: | Zeile 1.866: | ||

Theoretische Idee für vor dem create: mit revert-reshape und --backup-file ('''NICHT gemacht''', da das mal zu Datenverlust geführt hat!) | Theoretische Idee für vor dem create: mit revert-reshape und --backup-file ('''NICHT gemacht''', da das mal zu Datenverlust geführt hat!) | ||

mdadm --assemble --update=revert-reshape /dev/md126 /dev/sds1 /dev/sdaj1 /dev/sdn1 /dev/sdt1 /dev/sdq1 /dev/sdak1 /dev/sdy1 /dev/sdv1 /dev/sdao1 /dev/sdab1 /dev/sdaa1 /dev/sdad1 /dev/sdan1 /dev/sdj1 /dev/sdl1 /dev/sdx1 /dev/sdk1 /dev/sdah1 /dev/sdae1 /dev/sdc1 /dev/sda1 /dev/sdp1 /dev/sdb1 --backup-file=/home/gagi/mda127backup2 | mdadm --assemble --update=revert-reshape /dev/md126 /dev/sds1 /dev/sdaj1 /dev/sdn1 /dev/sdt1 /dev/sdq1 /dev/sdak1 /dev/sdy1 /dev/sdv1 /dev/sdao1 /dev/sdab1 /dev/sdaa1 /dev/sdad1 /dev/sdan1 /dev/sdj1 /dev/sdl1 /dev/sdx1 /dev/sdk1 /dev/sdah1 /dev/sdae1 /dev/sdc1 /dev/sda1 /dev/sdp1 /dev/sdb1 --backup-file=/home/gagi/mda127backup2 | ||

= 86. Raid Recreate DATA und DATA2 2023-11-10, 14TB HDD bb-Test über Nacht = | |||

44 Platten insgesamt | |||

'''DATA2 mit normalem mdadm''' | |||

u an hv 4 z ad ac w 8 al ag oc 12 aj te ae 16 a am fy 20 lj ap | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/sdu1 /dev/sdan1 /dev/sdh1 /dev/sdv1 /dev/sdz1 /dev/sdad1 /dev/sdac1 /dev/sdw1 /dev/sdal1 /dev/sdag1 /dev/sdo1 /dev/sdc1 /dev/sdaj1 /dev/sdt1 /dev/sde1 /dev/sdae1 /dev/sda1 /dev/sdam1 /dev/sdf1 /dev/sdy1 /dev/sdl1 /dev/sdj1 /dev/sdap1 | |||

ist ja jetzt EXT4 statt XFS, d.h. checken geht mit: | |||

e2fsck -v /dev/mapper/cr_md126 | |||

'''DATA mit normalem mdadm und offset''' | |||

ai pnd 4 ah sk aq 8 b aa x ao 12 girq 16 m ak ab af 20 | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/sdai1 /dev/sdp1 /dev/sdn1 /dev/sdd1 /dev/sdah1 /dev/sds1 /dev/sdk1 /dev/sdaq1 /dev/sdb1 /dev/sdaa1 /dev/sdx1 /dev/sdao1 /dev/sdg1 /dev/sdi1 /dev/sdr1 /dev/sdq1 /dev/sdm1 /dev/sdak1 /dev/sdab1 /dev/sdaf1 | |||

= 87. Raid Recreate DATA und DATA2 2024-04-30, Copy-Job von Myth, vielen Platten fielen raus= | |||

44 Platten insgesamt | |||

'''DATA2 mit normalem mdadm''' | |||

m af es 4 o ao xu 8 an ac y ah 12 ak lb w 16 n ad ae v 20 ci am | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/sdm1 /dev/sdaf1 /dev/sde1 /dev/sds1 /dev/sdo1 /dev/sdao1 /dev/sdx1 /dev/sdu1 /dev/sdan1 /dev/sdac1 /dev/sdy1 /dev/sdah1 /dev/sdak1 /dev/sdl1 /dev/sdb1 /dev/sdw1 /dev/sdn1 /dev/sdad1 /dev/sdae1 /dev/sdv1 /dev/sdc1 /dev/sdi1 /dev/sdam1 | |||

ist ja jetzt EXT4 statt XFS, d.h. checken geht mit: | |||

e2fsck -v /dev/mapper/cr_md126 | |||

'''DATA mit normalem mdadm und offset''' | |||

ar jkz 4 aj h aa al 8 f ag r ap 12 dgpa 16 t ai q ab 20 | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/sdar1 /dev/sdj1 /dev/sdk1 /dev/sdz1 /dev/sdaj1 /dev/sdh1 /dev/sdaa1 /dev/sdal1 /dev/sdf1 /dev/sdag1 /dev/sdr1 /dev/sdap1 /dev/sdd1 /dev/sdg1 /dev/sdp1 /dev/sda1 /dev/sdt1 /dev/sdai1 /dev/sdq1 /dev/sdab1 | |||

= 88. Raid Recreate DATA und DATA2 2024-05-08, einfach so, viele Platten fallen raus= | |||

44 Platten insgesamt | |||

'''DATA2 mit normalem mdadm''' | |||

t ae ku 4 aa an qc 8 al z y am 12 ai lof 16 n ac vm 20 as aj | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/sdt1 /dev/sdae1 /dev/sdk1 /dev/sdu1 /dev/sdaa1 /dev/sdan1 /dev/sdq1 /dev/sdc1 /dev/sdal1 /dev/sdz1 /dev/sdy1 /dev/sdam1 /dev/sdai1 /dev/sdl1 /dev/sdo1 /dev/sdf1 /dev/sdn1 /dev/sdac1 /dev/sdv1 /dev/sdm1 /dev/sda1 /dev/sds1 /dev/sdaj1 | |||

ist ja jetzt EXT4 statt XFS, d.h. checken geht mit: | |||

e2fsck -v /dev/mapper/cr_md126 | |||

'''DATA mit normalem mdadm und offset''' | |||

ak j ab ah 4 ag h af ap 8 g ad e ao 12 rpdb 16 i aq w x 20 | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/sdak1 /dev/sdj1 /dev/sdab1 /dev/sdah1 /dev/sdag1 /dev/sdh1 /dev/sdaf1 /dev/sdap1 /dev/sdg1 /dev/sdad1 /dev/sde1 /dev/sdao1 /dev/sdr1 /dev/sdp1 /dev/sdd1 /dev/sdb1 /dev/sdi1 /dev/sdaq1 /dev/sdw1 /dev/sdx1 | |||

= 89. Raid Recreate DATA und DATA2 2024-05-25, einfach so, viele Platten fallen raus= | |||

44 Platten insgesamt | |||

'''DATA2 mit normalem mdadm''' | |||

b ah nc 4 q ai vw 8 ao aa x ab 12 al mgt 16 a an ag e 20 hp am | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/sdb1 /dev/sdah1 /dev/sdn1 /dev/sdc1 /dev/sdq1 /dev/sdai1 /dev/sdv1 /dev/sdw1 /dev/sdao1 /dev/sdaa1 /dev/sdx1 /dev/sdab1 /dev/sdal1 /dev/sdm1 /dev/sdg1 /dev/sdt1 /dev/sda1 /dev/sdan1 /dev/sdag1 /dev/sde1 /dev/sdh1 /dev/sdp1 /dev/sdam1 | |||

ist ja jetzt EXT4 statt XFS, d.h. checken geht mit: | |||

e2fsck -v /dev/mapper/cr_md126 | |||

'''DATA mit normalem mdadm und offset''' | |||

ak ldz 4 aj o ac aq 8 i ae y ap 12 frjk 16 s ad u af 20 | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/sdak1 /dev/sdl1 /dev/sdd1 /dev/sdz1 /dev/sdaj1 /dev/sdo1 /dev/sdac1 /dev/sdaq1 /dev/sdi1 /dev/sdae1 /dev/sdy1 /dev/sdap1 /dev/sdf1 /dev/sdr1 /dev/sdj1 /dev/sdk1 /dev/sds1 /dev/sdad1 /dev/sdu1 /dev/sdaf1 | |||

= 90. Raid Recreate DATA und DATA2 2024-10-09, einfach so, viele Platten fallen raus= | |||

44 Platten insgesamt | |||

beide waren noch als Raid6 erkannt und mit Platten drin, aber warum zum Teil die falschen Platten und vor allem hatten die keine Platzzuordnung mehr. | |||

'''DATA2 mit normalem mdadm''' | |||

r ah dq 4 o ai xu 8 ap aa z ac 12 al icw 16 k ag ad e 20 ap ao | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/sdr1 /dev/sdah1 /dev/sdd1 /dev/sdq1 /dev/sdo1 /dev/sdai1 /dev/sdx1 /dev/sdu1 /dev/sdap1 /dev/sdaa1 /dev/sdz1 /dev/sdac1 /dev/sdal1 /dev/sdi1 /dev/sdc1 /dev/sdw1 /dev/sdk1 /dev/sdag1 /dev/sdad1 /dev/sde1 /dev/sda1 /dev/sdp1 /dev/sdao1 | |||

ist ja jetzt EXT4 statt XFS, d.h. checken geht mit: | |||

e2fsck -v /dev/mapper/cr_md126 | |||

'''DATA mit normalem mdadm und offset''' | |||

ak gs ab 4 aj h ae ar 8 j aq v am 12 bmlf 16 n af t y 20 | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/sdak1 /dev/sdg1 /dev/sds1 /dev/sdab1 /dev/sdaj1 /dev/sdh1 /dev/sdae1 /dev/sdar1 /dev/sdj1 /dev/sdaq1 /dev/sdv1 /dev/sdam1 /dev/sdb1 /dev/sdm1 /dev/sdl1 /dev/sdf1 /dev/sdn1 /dev/sdaf1 /dev/sdt1 /dev/sdy1 | |||

= 91. Raid Recreate DATA und DATA2 2024-10-09-II, einfach so, viele Platten fallen raus, Wechsel auf Identifikation nach disk/by-id anstatt der wechselnden Laufwerksbezeichnungen wie sda1 = | |||

44 Platten insgesamt | |||

beide waren noch als Raid6 erkannt und mit Platten drin, aber warum zum Teil die falschen Platten und vor allem hatten die keine Platzzuordnung mehr. | |||

'''Umstellung auf Identifikation nach disk/by-id anstatt der wechselnden Laufwerksbezeichnungen wie sda1''' | |||

udevadm info --query=all --name=/dev/sdi | grep disk/by-id/ata | |||

Eintragungen in disknum.txt und im Wiki ergänzt | |||

'''DATA2 mit normalem mdadm''' | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCE9215Q0AUYTW-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCM9215Q0B9LSY-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ0351YNGA02YA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K5THL257-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG09EDA-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHAWE09-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L359DL-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L7H2HV-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00AZ6B0_WD-WCC070299387-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N6EVNFZ5-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N1ZY6VVY-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K0SNC8T6-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N7CXVHLU-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG4J48A-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N3CHNN7K-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N5DZ1CEU-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60B6RZ-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N4NHKFN0-part1 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDH906SD-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7821M-part1 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDHBBDY5-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CK42-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CTY3-part1 | |||

'''DATA mit normalem mdadm und offset''' | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3WZVA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SYKA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K7VCRJZT-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2DJ9XL8-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG38VGA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3Y4SA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N0RC60LS-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG25Z6A-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3RM5A-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NT5A-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K2JL6DSL-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NZ3A-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3UUPA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SAMA-part1 /dev/disk/by-id/ata-TOSHIBA_DT01ABA300_234BGY0GS-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7743F-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHB5RY6-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2JPEN1D-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHA9E6A-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW6078X8-part1 | |||

= 92. Raid Recreate DATA und DATA2 2025-07-16, einfach so, viele Platten fallen raus, Wechsel auf Identifikation nach disk/by-id anstatt der wechselnden Laufwerksbezeichnungen wie sda1 = | |||

44 Platten insgesamt | |||

beide waren noch als Raid6 erkannt und mit Platten drin, aber warum zum Teil die falschen Platten und vor allem hatten die keine Platzzuordnung mehr. | |||

'''Umstellung auf Identifikation nach disk/by-id anstatt der wechselnden Laufwerksbezeichnungen wie sda1''' | |||

udevadm info --query=all --name=/dev/sdi | grep disk/by-id/ata | |||

Eintragungen in disknum.txt und im Wiki ergänzt | |||

'''DATA2 mit normalem mdadm -> passt so''' | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCE9215Q0AUYTW-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCM9215Q0B9LSY-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ0351YNGA02YA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K5THL257-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG09EDA-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHAWE09-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L359DL-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L7H2HV-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00AZ6B0_WD-WCC070299387-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N6EVNFZ5-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N1ZY6VVY-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K0SNC8T6-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N7CXVHLU-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG4J48A-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N3CHNN7K-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N5DZ1CEU-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60B6RZ-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N4NHKFN0-part1 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDH906SD-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7821M-part1 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDHBBDY5-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CK42-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CTY3-part1 | |||

'''DATA mit normalem mdadm und offset -> eine Platte anders als bei 91., da diese dazwischen getauscht wurde (8. Position /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW60FC09-part1 ist anders/Neu) !''' | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3WZVA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SYKA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K7VCRJZT-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2DJ9XL8-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG38VGA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3Y4SA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N0RC60LS-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW60FC09-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3RM5A-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NT5A-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K2JL6DSL-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NZ3A-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3UUPA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SAMA-part1 /dev/disk/by-id/ata-TOSHIBA_DT01ABA300_234BGY0GS-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7743F-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHB5RY6-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2JPEN1D-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHA9E6A-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW6078X8-part1 | |||

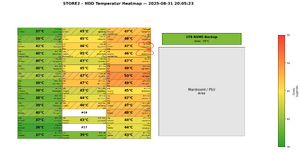

= 93. 2025-08-31 Raid Baubefehl noch data2 rebuild wegen HDD-Tausch mit disk/by-id = | |||

[[Datei:2025-08-31 20-05-23-STORE2-HDD-Heatmap Problem-Platten dmesg.png|mini|2025-08-31 20-05-23-STORE2-HDD-Heatmap Problem-Platten dmesg]] | |||

44 Platten insgesamt | |||

Eintragungen in disknum.txt und im Wiki ergänzt | |||

'''DATA2 mit normalem mdadm -> passt so''' | |||

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=23 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCE9215Q0AUYTW-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCM9215Q0B9LSY-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ0351YNGA02YA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K5THL257-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG09EDA-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHAWE09-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L359DL-part1 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L7H2HV-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW633NRC-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N6EVNFZ5-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N1ZY6VVY-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K0SNC8T6-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N7CXVHLU-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG4J48A-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N3CHNN7K-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N5DZ1CEU-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60B6RZ-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N4NHKFN0-part1 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDH906SD-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7821M-part1 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDHBBDY5-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CK42-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CTY3-part1 | |||

'''DATA mit normalem mdadm und offset -> eine Platte anders als bei 92., da diese dazwischen getauscht wurde (43. Position /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW60FC09-part1 ist anders/Neu) !''' | |||

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 --data-offset=1024 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3WZVA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SYKA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K7VCRJZT-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2DJ9XL8-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG38VGA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3Y4SA-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N0RC60LS-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW60FC09-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3RM5A-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NT5A-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K2JL6DSL-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NZ3A-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3UUPA-part1 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SAMA-part1 /dev/disk/by-id/ata-TOSHIBA_DT01ABA300_234BGY0GS-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7743F-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHB5RY6-part1 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2JPEN1D-part1 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHA9E6A-part1 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW6078X8-part1 | |||

= Spare-Group einrichten = | = Spare-Group einrichten = | ||

| Zeile 1.943: | Zeile 2.106: | ||

badblocks -vs -o sdy-badblock-test /dev/sdy | badblocks -vs -o sdy-badblock-test /dev/sdy | ||

bzw. bei sehr großen Platten (>8TB) noch mit dieser Option | |||

badblocks -vs -b4096 -o 14badblock-test /dev/sdau | |||

verbose, show progress, output-file (log) | verbose, show progress, output-file (log) | ||

badblocks sucht nur nach bad blocks, zerstört aber keine Daten. | badblocks sucht nur nach bad blocks, zerstört aber keine Daten. | ||

Aktuelle Version vom 17. September 2025, 18:56 Uhr

STABILITÄT Store 2.0

Vermutung: Die drei SATA-Erweiterungskarten crashen gelegentlich das komplette System.

Karten:

http://www.sybausa.com/productInfo.php?iid=537

Syba SY-PEX40008 4-port SATA II PCI-e Software RAID Controller Card--Bundle with Low Profile Bracket, SIL3124 Chipset Sind die identischen Karten, die immer noch von Backblaze verbaut werden (Pod 2.0 UND Pod 3.0!) Hängen an drei PCI-E 1x (kleiner Port)

RAID bliebt heile (zum Glück!), da die Karten dann komplett die Zugriff sperren.

Arch-Log files haben gar keine Einträge zu den Crashs!!!

Remote-Log über Syslogd (über Myth) zeigt als letzten Eintrag:

mdadm: sending ioctl 1261 to a partition (buggy Eintrag, aber unkritisch) sata_sil24: IRQ status == 0xffffffff, PCI fault or device removal

sata-sil24:

https://ata.wiki.kernel.org/index.php/Sata_sil24

Spurious interrupts are expected on SiI3124 suffering from IRQ loss erratum on PCI-X

PATCH?

http://old.nabble.com/-PATCH-06-13--sata_sil24%3A-implement-loss-of-completion-interrupt-on-PCI-X-errta-fix-p3799674.html

Thread über Zugang mit SIL3124 Chip

http://www.linuxquestions.org/questions/linux-kernel-70/how-to-access-sata-drives-attached-to-sii3124-719408/

Test?

http://marc.info/?l=linux-ide&m=127228317404771&w=2

Raid nach Booten öffnen und mount

Um Auto-Assembly beim Booten zu verhindern muss die Config-Datei /etc/mdadm.conf leer (oder zumindest komplett auskommentiert sein) und "MDADM_SCAN=no" in /etc/sysconfig/mdadm

1.) Checken ob alle Platten da sind:

/usr/local/bin/ds.sh

Müssen im Moment 17 Platten sein. Basis ist die Datei disknum.txt unter /root/bin

2.) Raids suchen und assemblen (kein Autostart):

mdadm --assemble --scan

3.) Cryptsetup:

cryptsetup luksOpen /dev/md125 cr_md125

4.) Mounten:

mount /dev/mapper/cr_md125 /data

Wichtig, speziell für data2 mit ext4 und ghost-inodes:

mount -o rw,errors=continue,noatime /dev/mapper/cr_md126 /data2

Schliessen wäre:

cryptsetup luksClose cr_md125

JD2

java -Xmx512m -jar /home/gagi/jd2/JDownloader.jar

bzw in /home/gagi/jd2/

./JDownloader2

VNC

dergagi.selfhost.bz:5901

NextCloud

Anleitung überhaupt

https://www.howtoforge.de/anleitung/wie-man-nextcloud-unter-debian-10-installiert/

DuckDNS und Letsencrypt

https://www.edvpfau.de/wildcard-zertifikat-mit-duckdns-erstellen/

1. Wildcard Zertifikat holen:

certbot --server https://acme-v02.api.letsencrypt.org/directory -d *.dergagi9.duckdns.org --manual --preferred-challenges dns-01 certonly

Einmal "Y" drücken und dann offen lassen für später

2. Secret setzen, dabei Token von DuckDNS-Account verwenden, das hintere ist aus der ersten Abfrage einzusetzen

curl "https://www.duckdns.org/update?domains=dergagi9.duckdns.org&token=51570840-8ed4-403a-8090-30f4dacc3b2f&txt=rL-ALVVDfHal08GUWz1T0PAevUOcWT-HgvJ7eMd0J6o"

3. Prüfen, ob TXT record gesetzt ist:

https://www.digwebinterface.com/?hostnames=dergagi9.duckdns.org&type=TXT&ns=resolver&useresolver=8.8.4.4&nameservers=

4. Certbot Validierung fortsetzen

dann erst im ersten Fenster "Return" drücken

NEU 2022-02: Automatisiertes Skript zur Zertifikatsaktualisierung, wie hier beschrieben

https://www.edvpfau.de/automatische-erneuerung-der-letsencrypt-wildcard-zertifikate-mit-duckdns/

______________________________________________________________________

Dateien "locked", können also z.B. nicht gelöscht werden

put Nextcloud in maintenance mode:

gedit /var/www/html/nextcloud/config/config.php

and change this line: 'maintenance' => true,

Empty table oc_file_locks: Use tool mysql run (the default table prefix is oc_, this prefix can be different or even empty):

mysql -u nextclouduser -p nextclouddb

password Dann ist man in MaridDb eingeloggt; darin dann:

DELETE FROM oc_file_locks WHERE 1; \q

disable maintenance mode (undo first step)

gedit /var/www/html/nextcloud/config/config.php

and change this line: 'maintenance' => false,

Festplatten-Layout

3000GB Hitachi Deskstar 5K3000 HDS5C3030ALA630 CoolSpin 32MB 3.5" (8.9cm) SATA 6Gb/s

3000GB Western Digital WD30EZRX 3TB interne Festplatte (8,9 cm (3,5 Zoll), 5400 rpm, 2ms, 64MB Cache, SATA III

Problem mit WD-Platten und LCC

http://idle3-tools.sourceforge.net/ http://koitsu.wordpress.com/2012/05/30/wd30ezrx-and-aggressive-head-parking/

Get idle3 timer raw value

idle3ctl -g /dev/sdh

Disable idle3 timer:

idle3ctl -d /dev/sdh

Serial auslesen mit:

udevadm info --query=all --name=/dev/sdi | grep ID_SERIAL_SHORT

Für /dev/disk/by-id

udevadm info --query=all --name=/dev/sdi1 | grep disk/by-id/ata

Serial Systemplatte 160GB:

JC0150HT0J7TPC

Serials der Datenplatten

00 : 00000000000000 (1TB System (Arch), Samsung) /dev/disk/by-id/ata-SAMSUNG_HD103UJ_00000000000000

geht

01 : 234BGY0GS (3TB Toshiba) data 014 /dev/disk/by-id/ata-TOSHIBA_DT01ABA300_234BGY0GS-part1 02 : ZDHB5RY6 (3TB Ironwolf NAS) data 016 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHB5RY6-part1 03 : ZGY7743F (3TB Ironwolf NAS) data 015 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7743F-part1 04 : MJ1311YNG3Y4SA (3TB Toshiba) data 005 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3Y4SA-part1 05 : MJ1311YNG3SYKA (3TB Toshiba) data 001 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SYKA-part1

geht jetzt auch, Molex-Kontakt Problem behoben

06 : MJ1311YNG4J48A (3TB Toshiba) data2 113 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG4J48A-part1 07 : WW60B6RZ (4TB Seagate Ironwolf Slim) data2 116 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60B6RZ-part1 08 : WD-WCC4N3CHNN7K (3TB WD Red) data2 114 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N3CHNN7K-part1 09 : MJ1311YNG3UUPA (3TB Toshiba) data 012 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3UUPA-part1 10 : MJ0351YNGA02YA (3TB Toshiba) data2 102 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ0351YNGA02YA-part1

geht

11 : MJ1311YNG3SAMA (3TB) data 013 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3SAMA-part1 -> potentiell gefährded, hat 6 Pending Sectors, 13,5 Jahre alt -> evtl. proaktiv tauschen 12 : WW60CK42 (4TB Seagate IronWolf Slim) data2 121 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CK42-part1 13 : MJ1311YNG09EDA (3TB) data2 104 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG09EDA-part1 14 : WD-WCC7K7VCRJZT (3TB WD Red) data 002 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K7VCRJZT-part1 15 : MCE9215Q0AUYTW (3TB Toshiba) data2 100 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCE9215Q0AUYTW-part1

geht

16 : ZDHBBDY5 (4TB Seagate Ironwolf) data2 120 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDHBBDY5-part1 17 : 18 : ZGY7821M (3TB Seagate IronWolf) data2 119 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZGY7821M-part1 19 : 20 : MJ1311YNG3RM5A (3TB Toshiba) data 008 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3RM5A-part1

geht

21 : WD-WCC7K5THL257 (3TB WD Red) data2 103 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K5THL257-part1 22 : ZDHA9E6A (3TB Seagate Ironwolf) data 018 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHA9E6A-part1 23 : WD-WMC4N0L7H2HV (3TB WD) data2 107 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L7H2HV-part1 24 : WD-WCC7K2JL6DSL (3TB WD Red) data 010 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K2JL6DSL-part1 25 : WD-WCC4N5DZ1CEU (3TB WD Red) data2 115 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N5DZ1CEU-part1

geht

26 : WD-WMC4N0L359DL (3TB WD) data2 106 /dev/disk/by-id/ata-WDC_WD30EZRX-00D8PB0_WD-WMC4N0L359DL-part1 27 : WW6078X8 (4TB Seagate IronWolf Slim) data 019 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW6078X8-part1 28 : WD-WCC4N1ZY6VVY (3TB WD Red) data2 110 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N1ZY6VVY-part1 29 : WD-WCC4N6EVNFZ5 (3TB WD Red) data2 109 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N6EVNFZ5-part1 30 : WD-WCC4N2DJ9XL8 (3TB WD Red) data 003 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2DJ9XL8-part1

geht

31 : MJ1311YNG3NT5A (3TB Toshiba) data 009 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NT5A-part1 32 : MCM9215Q0B9LSY (3TB Toshiba) data2 101 /dev/disk/by-id/ata-Hitachi_HDS5C3030BLE630_MCM9215Q0B9LSY-part1 33 : ZDHAWE09 (3TB Seagate Ironwolf) data2 105 /dev/disk/by-id/ata-ST3000VN007-2AH16M_ZDHAWE09-part1 34 : MJ1311YNG38VGA (3TB Toshiba) data 004 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG38VGA-part1 35 : MJ1311YNG3WZVA (3TB Toshiba) data 000 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3WZVA-part1

geht

36 : WD-WCC7K0SNC8T6 (3TB WD Red) data2 111 /dev/disk/by-id/ata-WDC_WD30EFRX-68N32N0_WD-WCC7K0SNC8T6-part1 37 : ZDH906SD (4TB Seagate Ironwolf) data2 118 /dev/disk/by-id/ata-ST4000VN008-2DR166_ZDH906SD-part1 38 : WD-WCC4N0RC60LS (3TB WD Red) data 006 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N0RC60LS-part1 39 : WD-WCC4N2JPEN1D (3TB WD Red) data 017 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N2JPEN1D-part1 40 : WD-WCC4N4NHKFN0 (3TB WD Red) data2 117 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N4NHKFN0-part1

geht

41 : WD-WCC4N7CXVHLU (3TB WD Red) data2 112 /dev/disk/by-id/ata-WDC_WD30EFRX-68EUZN0_WD-WCC4N7CXVHLU-part1 42 : WW60CTY3 (4TB Seagate IronWolf Slim) data2 122 /dev/disk/by-id/ata-ST4000VN006-3CW104_WW60CTY3-part1 43 : ZW633NRC (4TB IronWolf Slim) data2 108 /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW633NRC-part1 44 : MJ1311YNG3NZ3A (3TB Toshiba) data 011 /dev/disk/by-id/ata-Hitachi_HDS5C3030ALA630_MJ1311YNG3NZ3A-part1 45 : ZW60FC09 (4TB Seagate IronWolf Slim) data 007 /dev/disk/by-id/ata-ST4000VN006-3CW104_ZW60FC09-part1

TOTAL: 44 (20 + 23 + 0 SPARE (extern aber vorbereitet und getestet) + 1 Systemplatte) von 46 möglichen

Mapping der Festplatte mit fixer Zuordnung statt sdx

https://superuser.com/questions/617192/mapping-ata-device-number-to-logical-device-name

Raid Baubefehl

im Screen mdadm

mdadm --create /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=15 /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1 /dev/sdf1 /dev/sdg1 /dev/sdh1 /dev/sdi1 /dev/sdj1 /dev/sdk1 /dev/sdl1 /dev/sdm1 /dev/sdn1 /dev/sdo1 /dev/sdp1

Re-Create 2014-01-31:

NEUER RICHTIGER RE-CREATE BEFEHL von mdadm-git:

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdb1:1024 /dev/sdd1:1024 /dev/sdf1:1024 /dev/sdg1:1024 /dev/sdh1:1024 /dev/sdc1:1024 /dev/sdt1:1024 /dev/sdn1:1024 /dev/sdo1:1024 /dev/sdq1:1024 /dev/sdm1:1024 /dev/sdp1:1024 /dev/sdu1:1024 /dev/sdv1:1024 /dev/sda1:1024 /dev/sds1:1024 /dev/sdl1:1024 /dev/sdw1:1024

Re-Create 2014-05-23: NEUER RICHTIGER RE-CREATE BEFEHL von mdadm-git aus /builds/mdadm/:

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdb1:1024 /dev/sdd1:1024 /dev/sdf1:1024 /dev/sdg1:1024 /dev/sdh1:1024 /dev/sdc1:1024 /dev/sdt1:1024 /dev/sdm1:1024 /dev/sdn1:1024 /dev/sdp1:1024 /dev/sdl1:1024 /dev/sdo1:1024 /dev/sdu1:1024 /dev/sdv1:1024 /dev/sda1:1024 /dev/sds1:1024 /dev/sdk1:1024 /dev/sdw1:1024

Re-Create 2014-07-10: NEUER RICHTIGER RE-CREATE BEFEHL von mdadm-git aus /builds/mdadm/:

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdb1:1024 /dev/sdd1:1024 /dev/sdf1:1024 /dev/sdg1:1024 /dev/sdh1:1024 /dev/sdc1:1024 /dev/sdt1:1024 /dev/sdn1:1024 /dev/sdo1:1024 /dev/sdq1:1024 /dev/sdm1:1024 /dev/sdp1:1024 /dev/sdu1:1024 /dev/sdv1:1024 /dev/sda1:1024 /dev/sds1:1024 /dev/sdl1:1024 /dev/sdw1:1024

Zweites Raid Baubefehl DATA2

im Screen mdadm

mdadm --create /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=4 /dev/sdv1 /dev/sdw1 /dev/sdj1 /dev/sdh1

Verschlüsseln mit speziellen Paramtern für Hardware-Verschlüsselung:

cryptsetup -v luksFormat --cipher aes-cbc-essiv:sha256 --key-size 256 /dev/md126

Öffnen:

cryptsetup luksOpen /dev/md126 cr_md126

XFS Filesystem drauf:

mkfs.xfs /dev/mapper/cr_md126

Versuch Recreate 2014-10-12 nach missglücktem Grow von 4 auf 5 RAID-Devices, scheiße:

./mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=4 /dev/sdy1:1024 /dev/sdq1:1024 /dev/sdi1:1024 /dev/sdj1:1024

Echtes Recreate 2014-10-12:

mdadm --create /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdq1 /dev/sdi1 /dev/sdj1 /dev/sdx1

Vierter (Dritter nicht dokumentiert) Raid Baubefehl DATA2 2021-10-28

mdadm --create /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=20 /dev/sdm1 /dev/sdag1 /dev/sdi1 /dev/sdn1 /dev/sdk1 /dev/sdb1 /dev/sdw1 /dev/sdo1 /dev/sdal1 /dev/sdy1 /dev/sdx1 /dev/sdaa1 /dev/sdak1 /dev/sdu1 /dev/sdg1 /dev/sdq1 /dev/sds1 /dev/sdae1 /dev/sdab1 /dev/sdt1

cryptsetup -v luksFormat --cipher aes-cbc-essiv:sha256 --key-size 256 /dev/md126

cryptsetup luksOpen /dev/md126 cr_md126

mkfs.xfs /dev/mapper/cr_md126

_________ 2021-11-18 nach normalem Reboot (Netzwerk war weg) ließ sich data2 nicht mehr mounten ("can't read superblock"), ist aber ein XFS-Problem, kein mdadm-Problem. xfs_repair lief nicht an (mount first etc. pp; -L Option NICHT genutzt) LÖSUNG: Reboot -> mdadm --stop -> mdadm --create --assume-clean etc. pp. -> dann mounten, dauert zwar sehr lange (ca. 20 Minuten), hat dann aber geklappt und alle Daten noch da

Drittes Raid Recreate DATA und DATA2 2015-01-20

./mdadm --create /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdk1:1024 /dev/sdx1:1024

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdm1:1024 /dev/sdo1:1024 /dev/sdi1:1024 /dev/sdb1:1024 /dev/sdp1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdf1:1024 /dev/sdd1:1024 /dev/sdh1:1024 /dev/sde1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdk1:1024 /dev/sdq1:1024 /dev/sdc1:1024 /dev/sdv1:1024

Builden OHNE Spare, also 18 Devices, dann Spare adden

Viertes Raid Recreate DATA 2015-02-01

in /root/bin

./diskserial2.sh

um die Festplattenreihenfolge im Raid zu sehen. Ohne hddtemp etc. wohl auch stabiler

mdadm aus /builds/mdadm

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdo1:1024 /dev/sdd1:1024 /dev/sdk1:1024 /dev/sdg1:1024 /dev/sdp1:1024 /dev/sdb1:1024 /dev/sdr1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdj1:1024 /dev/sde1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdm1:1024 /dev/sdq1:1024 /dev/sdc1:1024 /dev/sdv1:1024

Mit normalem mdadm gehts wohl auch

mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdo1 /dev/sdd1 /dev/sdk1 /dev/sdg1 /dev/sdp1 /dev/sdb1 /dev/sdr1 /dev/sdf1 /dev/sdh1 /dev/sdj1 /dev/sde1 /dev/sdg1 /dev/sds1 /dev/sdu1 /dev/sdm1 /dev/sdq1 /dev/sdc1 /dev/sdv1

Builden OHNE Spare, also 18 Devices, dann Spare adden

PROBLEM:

mdadm: failed to open /dev/sdg1 after earlier success - aborting

Fünftes Raid Recreate DATA 2015-02-28

in /root/bin

./diskserial2.sh

um die Festplattenreihenfolge im Raid zu sehen.

mdadm aus /builds/mdadm

dqelcpfhmakgsunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdq1:1024 /dev/sde1:1024 /dev/sdl1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdm1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

Builden OHNE Spare, also 18 Devices, dann Spare adden

Sechstes Raid Recreate DATA und DATA2 2015-03-11

3 neue aber identische Sil-Sata Raid PCI1x Karten mit Firmware 2.6.18

in /root/bin

./diskserial2.sh

um die Festplattenreihenfolge im Raid zu sehen.

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

dqemcpfhialgsunrkv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdq1:1024 /dev/sde1:1024 /dev/sdm1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdi1:1024 /dev/sda1:1024 /dev/sdl1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdk1:1024 /dev/sdv1:1024

Builden OHNE Spare, also 18 Devices, dann Spare adden

Siebtes Raid Recreate DATA und DATA2 2015-03-15

3 neue aber identische Sil-Sata Raid PCI1x Karten mit Firmware 2.6.18

in /root/bin

./diskserial2.sh

um die Festplattenreihenfolge im Raid zu sehen.

DATA2 mit normalem mdadm

ybixw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdi1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqjdcprtgalshunfkv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdj1:1024 /dev/sdd1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdr1:1024 /dev/sdt1:1024 /dev/sdg1:1024 /dev/sda1:1024 /dev/sdl1:1024 /dev/sds1:1024 /dev/sdh1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdf1:1024 /dev/sdk1:1024 /dev/sdv1:1024

Builden OHNE Spare, also 18 Devices, dann Spare adden

Achtes Raid Recreate DATA und DATA2 2015-03-21

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfldpgicakhsunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdc1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

Neuntes Raid Recreate DATA und DATA2 2015-04-22

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfldpgimbkhsunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

Zehntes Raid Recreate DATA und DATA2 2015-04-24

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfldpgimbkhsunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

Elftes Raid Recreate DATA und DATA2 2015-04-26

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfmcpgidalhsunrkv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdm1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdd1:1024 /dev/sda1:1024 /dev/sdl1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdk1:1024 /dev/sdv1:1024

12. Raid Recreate DATA und DATA2 2015-05-06

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

dqel cpfh makg sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdq1:1024 /dev/sde1:1024 /dev/sdl1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdm1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

smartctl-timeouts ergänzt 2015-05-07

/etc/udev/rules.d/ http://article.gmane.org/gmane.linux.raid/48238/match=smartctl+timeouts

The smartctl-timeouts scripts fix commonly mismatching defaults with drives that have no error recovery timeout configured, which has often lead to data loss.

To test, extract the files to /etc/udev/rules.d/ and

- reboot*. For me, the rules somehow had no effect without rebooting.

13. Raid Recreate DATA und DATA2 2015-05-11

DATA2 mit normalem mdadm

xcswv

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdx1 /dev/sdc1 /dev/sds1 /dev/sdw1 /dev/sdv1

DATA mdadm aus /builds/mdadm

epfl dogi bakh rtmqju

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdo1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdb1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sdr1:1024 /dev/sdt1:1024 /dev/sdm1:1024 /dev/sdq1:1024 /dev/sdj1:1024 /dev/sdu1:1024

14. Raid Recreate DATA und DATA2 2015-05-14

DATA2 mit normalem mdadm

xbswv

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdx1 /dev/sdb1 /dev/sds1 /dev/sdw1 /dev/sdv1

DATA mdadm aus /builds/mdadm

dpek cofh lajg rtmqiu

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sde1:1024 /dev/sdk1:1024 /dev/sdc1:1024 /dev/sdo1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdl1:1024 /dev/sda1:1024 /dev/sdj1:1024 /dev/sdg1:1024 /dev/sdr1:1024 /dev/sdt1:1024 /dev/sdm1:1024 /dev/sdq1:1024 /dev/sdi1:1024 /dev/sdu1:1024

15. Raid Recreate DATA und DATA2 2015-05-20

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl dpgi mbkh sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

16. Raid Recreate DATA und DATA2 2015-05-21

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfb 4 dpgi 8 jalh 12 sunrkv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdb1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdj1:1024 /dev/sda1:1024 /dev/sdl1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdk1:1024 /dev/sdv1:1024

17. Raid Recreate DATA und DATA2 2015-05-22

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

cqfl 4 epgi 8 mbkh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdc1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sde1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

18. Raid Recreate DATA und DATA2 2015-05-23

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

fqga 4 ephj 8 mcli 12 sunrkv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdf1:1024 /dev/sdq1:1024 /dev/sdg1:1024 /dev/sda1:1024 /dev/sde1:1024 /dev/sdp1:1024 /dev/sdh1:1024 /dev/sdj1:1024 /dev/sdm1:1024 /dev/sdc1:1024 /dev/sdl1:1024 /dev/sdi1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdk1:1024 /dev/sdv1:1024

19. Raid Recreate DATA und DATA2 2015-05-24

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

fqgm 4 ephj 8 dbli 12 sunrkv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdf1:1024 /dev/sdq1:1024 /dev/sdg1:1024 /dev/sdm1:1024 /dev/sde1:1024 /dev/sdp1:1024 /dev/sdh1:1024 /dev/sdj1:1024 /dev/sdd1:1024 /dev/sdb1:1024 /dev/sdl1:1024 /dev/sdi1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdk1:1024 /dev/sdv1:1024

20. Raid Recreate DATA und DATA2 2015-05-31

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl 4 bpgi 8 mckh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdb1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdc1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

21. Raid Recreate DATA und DATA2 2015-06-06

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl 4 bpgi 8 mckh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdb1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdc1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

22. Raid Recreate DATA und DATA2 2015-06-09

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl 4 dpgi 8 mbkh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

23. Raid Recreate DATA und DATA2 2015-06-11

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl 4 dpgi 8 mbkh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

24. Raid Recreate DATA und DATA2 2015-06-12

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl 4 dpgi 8 mbkh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

25. Raid Recreate DATA und DATA2 2015-06-20, irgendwie in letztet Zeit immer nur, wenn die Tür geöffnet/bewegt wurde

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl 4 bpgi 8 mckh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdb1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdc1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

26. Raid Recreate DATA und DATA2 2015-06-27, irgendwie in letztet Zeit immer nur, wenn die Tür geöffnet/bewegt wurde

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

cqfl 4 epgi 8 mbkh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdc1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sde1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

27. Raid Recreate DATA und DATA2 2015-06-28

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

dqel 4 cpfh 8 makg 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdq1:1024 /dev/sde1:1024 /dev/sdl1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdm1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

28. Raid Recreate DATA und DATA2 2015-07-14

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

fqgm 4 ephj 8 bcli 12 sunrkv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdf1:1024 /dev/sdq1:1024 /dev/sdg1:1024 /dev/sdm1:1024 /dev/sde1:1024 /dev/sdp1:1024 /dev/sdh1:1024 /dev/sdj1:1024 /dev/sdb1:1024 /dev/sdc1:1024 /dev/sdl1:1024 /dev/sdi1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdk1:1024 /dev/sdv1:1024

29. Raid Recreate DATA und DATA2 2015-07-19

DATA2 mit normalem mdadm

xbswv

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdx1 /dev/sdb1 /dev/sds1 /dev/sdw1 /dev/sdv1

DATA mdadm aus /builds/mdadm

dpek 4 cofh 8 lajg 12 rtmqiu

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sde1:1024 /dev/sdk1:1024 /dev/sdc1:1024 /dev/sdo1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdl1:1024 /dev/sda1:1024 /dev/sdj1:1024 /dev/sdg1:1024 /dev/sdr1:1024 /dev/sdt1:1024 /dev/sdm1:1024 /dev/sdq1:1024 /dev/sdi1:1024 /dev/sdu1:1024

30. Raid Recreate DATA und DATA2 2015-07-26

DATA2 mit normalem mdadm

yctxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdc1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

eqfl 4 dpgi 8 mbkh 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdq1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdp1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

31. Raid Recreate DATA und DATA2 2015-07-27

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

dqek 4 cpfh 8 lajg 12 sunriv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdq1:1024 /dev/sde1:1024 /dev/sdk1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdl1:1024 /dev/sda1:1024 /dev/sdj1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdi1:1024 /dev/sdv1:1024

32. Raid Recreate DATA und DATA2 2015-08-09

DATA2 mit normalem mdadm

xbswv

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdx1 /dev/sdb1 /dev/sds1 /dev/sdw1 /dev/sdv1

DATA mdadm aus /builds/mdadm

epfl 4 dogi 8 cakh 12 rtmqju

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdo1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdc1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sdr1:1024 /dev/sdt1:1024 /dev/sdm1:1024 /dev/sdq1:1024 /dev/sdj1:1024 /dev/sdu1:1024

33. Raid Recreate DATA und DATA2 2015-08-20

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

DATA mdadm aus /builds/mdadm

dqel 4 cpfh 8 makg 12 sunrjv

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdq1:1024 /dev/sde1:1024 /dev/sdl1:1024 /dev/sdc1:1024 /dev/sdp1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sdm1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdg1:1024 /dev/sds1:1024 /dev/sdu1:1024 /dev/sdn1:1024 /dev/sdr1:1024 /dev/sdj1:1024 /dev/sdv1:1024

34. Raid Recreate NUR DATA2 2015-09-01 NACH NETZTEILWECHSEL

DATA2 mit normalem mdadm

ybtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdb1 /dev/sdt1 /dev/sdx1 /dev/sdw1

35. Raid Recreate NUR DATA2 2015-09-01 NACH NETZTEILWECHSEL nach interupted DATA2 Raid6 Grow

Grow mdadm --grow --raid-devices=6 /dev/md126 --backup-file=/home/gagi/mda126backup_20150911

DATA2 mit normalem mdadm

ydtxw

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=5 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1

Neu dazu kam dann sdo1

Versuch von --update=revert-reshape

--assemble --update=revert-reshape" can be used to undo a reshape that has just been started but isn't really wanted. This is very new and while it passes basic tests it cannot be guaranteed. mdadm --assemble --update=revert-reshape /dev/md126 /dev/sdy1 /dev/sdd1 /dev/sdt1 /dev/sdx1 /dev/sdw1 /dev/sdo1 --backup-file=/home/gagi/mda126backup_20150911

md126 Reshape läuft als Raid6 wieder normal an und hat auch resumed (bei ca. 1.5%) :-) in diesem Zustand lässt sich md126 auf decrypten und mounten, Daten sind da. Sieht also alles gut aus. Reshape dauert noch ca. 3400 Minunten, also ca. 2,36 Tage ;-)

36. Raid Recreate DATA und DATA2 2016-01-19 nach neuer Platte rein im Betrieb :-(

DATA2 mit normalem mdadm

aa cvz 4 yqo

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=7 /dev/sdaa1 /dev/sdc1 /dev/sdv1 /dev/sdz1 /dev/sdy1 /dev/sdq1 /dev/sdo1

DATA mdadm aus /builds/mdadm

esfl 4 drgi 8 mbkh 12 uwptjx

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sds1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdd1:1024 /dev/sdr1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sdb1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sdu1:1024 /dev/sdw1:1024 /dev/sdp1:1024 /dev/sdt1:1024 /dev/sdj1:1024 /dev/sdx1:1024

37. Raid Recreate DATA und DATA2 2016-07-07 nach Ultrastar-Indizierung

DATA2 mit normalem mdadm

ab bw aa 4 zrpo 8

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdab1 /dev/sdb1 /dev/sdw1 /dev/sdaa1 /dev/sdz1 /dev/sdr1 /dev/sdp1 /dev/sdo1

DATA mdadm aus /builds/mdadm

dtfm 4 csgi 8 nalh 12 vxquky

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdt1:1024 /dev/sdf1:1024 /dev/sdm1:1024 /dev/sdc1:1024 /dev/sds1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdn1:1024 /dev/sda1:1024 /dev/sdl1:1024 /dev/sdh1:1024 /dev/sdv1:1024 /dev/sdx1:1024 /dev/sdq1:1024 /dev/sdu1:1024 /dev/sdk1:1024 /dev/sdy1:1024

38. Raid Recreate DATA und DATA2 2016-07-07 nach Ultrastar-Indizierung

DATA2 mit normalem mdadm

aa bvz 4 yqon 8

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdaa1 /dev/sdb1 /dev/sdv1 /dev/sdz1 /dev/sdy1 /dev/sdq1 /dev/sdo1 /dev/sdn1

DATA mdadm aus /builds/mdadm

dsfl 4 crgi 8 makh 12 uwptjx

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sds1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdc1:1024 /dev/sdr1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sdu1:1024 /dev/sdw1:1024 /dev/sdp1:1024 /dev/sdt1:1024 /dev/sdj1:1024 /dev/sdx1:1024

39. Raid Recreate DATA und DATA2 2016-07-23

DATA2 mit normalem mdadm

ab bw aa 4 zrpo 8

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdab1 /dev/sdb1 /dev/sdw1 /dev/sdaa1 /dev/sdz1 /dev/sdr1 /dev/sdp1 /dev/sdo1

DATA mdadm aus /builds/mdadm

dtfl 4 csgi 8 makh 12 vxqujy

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sdt1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdc1:1024 /dev/sds1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sdv1:1024 /dev/sdx1:1024 /dev/sdq1:1024 /dev/sdu1:1024 /dev/sdj1:1024 /dev/sdy1:1024

40. Raid Recreate DATA und DATA2 2016-07-24

DATA2 mit normalem mdadm

ab cw aa 4 zrpo 8

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdab1 /dev/sdc1 /dev/sdw1 /dev/sdaa1 /dev/sdz1 /dev/sdr1 /dev/sdp1 /dev/sdo1

DATA mdadm aus /builds/mdadm

etgm 4 dshj 8 nbli 12 vxquky

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sde1:1024 /dev/sdt1:1024 /dev/sdg1:1024 /dev/sdm1:1024 /dev/sdd1:1024 /dev/sds1:1024 /dev/sdh1:1024 /dev/sdj1:1024 /dev/sdn1:1024 /dev/sdb1:1024 /dev/sdl1:1024 /dev/sdi1:1024 /dev/sdv1:1024 /dev/sdx1:1024 /dev/sdq1:1024 /dev/sdu1:1024 /dev/sdk1:1024 /dev/sdy1:1024

41. Raid Recreate DATA und DATA2 2016-07-26

DATA2 mit normalem mdadm

aa bvz 4 yqon 8

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdaa1 /dev/sdb1 /dev/sdv1 /dev/sdz1 /dev/sdy1 /dev/sdq1 /dev/sdo1 /dev/sdn1

DATA mdadm aus /builds/mdadm

dsfl 4 crgi 8 makh 12 uwptjx

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdd1:1024 /dev/sds1:1024 /dev/sdf1:1024 /dev/sdl1:1024 /dev/sdc1:1024 /dev/sdr1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdm1:1024 /dev/sda1:1024 /dev/sdk1:1024 /dev/sdh1:1024 /dev/sdu1:1024 /dev/sdw1:1024 /dev/sdp1:1024 /dev/sdt1:1024 /dev/sdj1:1024 /dev/sdx1:1024

42. Raid Recreate DATA2 2016-08-11 SATA-KARTEN UMGEBAUT, NEUES SCRIPT

DATA2 mit normalem mdadm

mvhl 4 kcsn 8

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdm1 /dev/sdv1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1

43. Raid Recreate NUR DATA2 2016-08-18 nach interupted DATA2 Raid6 Grow

Grow mdadm --grow --raid-devices=9 /dev/md126 --backup-file=/home/gagi/mda126backup

Dann ist bei ca. 45% das System gestallt (war heiß im Raum). Reboot -> md126 mit 9 Platten und clean, aber read-only und nicht mehr am Gown

DATA2 mit normalem mdadm

mvhl 4 kcsn

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdm1 /dev/sdv1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1

Also nut mit 8 Devices -> FEHLER! und blöde Idee. cryptsetup LuksOpen geht zwar noch richtig, aber Filesystem-Fehler beim mounten

Neu dazu kam dann sdz1

Versuch von --update=revert-reshape

--assemble --update=revert-reshape" can be used to undo a reshape that has just been started but isn't really wanted. This is very new and while it passes basic tests it cannot be guaranteed. mdadm --assemble --update=revert-reshape /dev/md126 /dev/sdm1 /dev/sdv1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1 /dev/sdz1

geht nicht, das 9. und neue Device sdz1 hat andere Superblock!

cryptsetup luksClose cr_md125

Nochmal createn mit 9, auch wenn 9. device sicher noch nicht richtig im Raid6 eingegrowt war. Allerdings könnte dann das Filesystem passen -> mount -> Daten da

lugk 4 jbrm 8 y

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdl1 /dev/sdu1 /dev/sdg1 /dev/sdk1 /dev/sdj1 /dev/sdb1 /dev/sdr1 /dev/sdm1 /dev/sdy1

mount: Einhängen von /dev/mapper/cr_md126 auf /data2 ist fehlgeschlagen: Die Struktur muss bereinigt werden

Besser, aber nochwas komisch. -> XFS-Check

xfs_repair /dev/mapper/cr_md126

Metadata corruption detected at xfs_bmbt block 0x60a0a30f8/0x1000 Metadata corruption detected at xfs_bmbt block 0x60a0a30f8/0x1000 bad magic # 0xc76d91a7 in inode 32617927112 (Daten fork) bmbt block 6322787567 bad data fork in inode 32617927112 cleared inode 32617927112

Dann noch viele andere Fehler und einiges in lost&found (vor allem auch viel vom neuen Singstar-Song-Archiv, davon aber zum Glück noch Backup auf 750er ToughDrive vorhanden) ABER: md126 lässt sich mit crypt entschlüsseln UND danach auch mounten -> meisten Daten also wieder da!

nochmal stop und dann nochmal

mvhl 4 kcsn 8 z mdadm --assemble --update=revert-reshape /dev/md126 /dev/sdm1 /dev/sdv1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1 /dev/sdz1

Klappt nicht! :-(

So wie ist gehts zwar das mounten, allerdings sind scheinbar viele Daten korrupt! :-(((

md126 stoppen

nur mit den ursprünglichen 8 devices baun

mvhl 4 kcsn

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=8 /dev/sdm1 /dev/sdv1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1

xfs_repair

Viele Fehler -> ohoh :-(( -> Shit alles weg bis auf 3TB lost&found

WICHTIG: DER GANZE UNTERBROCHENE GROW-PROZESS WÄRE WAHRSCHEINLICH EINFACH NACH DEM MOUNTEN (!!!) NORMAL WEITERGELAUFEN!!

Nochmal mit 9 aber 9. fehlend

mvhl 4 kcsn 8 z

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdm1 /dev/sdv1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1 missing

-> geht auf und wird gemountet -> wieder einiges da -> xfs_repair (3x) -> dann keiner Fehler mehr erkannt -> Viele alten Daten wieder OK, neuere (so ab 19.9.2015) größtenteils korrupt :-(

9. devices wieder dazu -> wird neu eingebunden

44. Raid ReSync-Stop DATA 2016-11-01

Nach Hänger wollte DATA (schon noch clean) resynchen, was dann immer noch einiger Zeit (mehrere Stunden, ca. 50%) ohne log-Eintrag hängen blieb. Dies hat auch bei mehreren Anläufen (ca. 6 Stück) nicht geklappt.

Laufenden ReSync stoppen:

echo frozen > /sys/block/md125/md/sync_action

Gestoppten ReSync als Complete setzen:

echo none > /sys/block/md125/md/resync_start

Danach auch xfs-repair

xfs_repair /dev/mapper/cr_md125

Cronjob ausgeschalten für Auto-Sync einmal im Monat

45. Raid Recreate DATA und DATA2 2016-11-08

DATA2 mit normalem mdadm

mwhl 4 kcsn 8 aa

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdm1 /dev/sdw1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1 /dev/sdaa1

DATA mdadm aus /builds/mdadm

yezq 4 xdu ac 8 rvp ab 12 gibfoj

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdy1:1024 /dev/sde1:1024 /dev/sdz1:1024 /dev/sdq1:1024 /dev/sdx1:1024 /dev/sdd1:1024 /dev/sdu1:1024 /dev/sdac1:1024 /dev/sdr1:1024 /dev/sdv1:1024 /dev/sdp1:1024 /dev/sdab1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdb1:1024 /dev/sdf1:1024 /dev/sdo1:1024 /dev/sdj1:1024

46. Raid Recreate DATA und DATA2 2016-12-05

DATA2 mit normalem mdadm

lwgk 4 jbsn 8 aa

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdl1 /dev/sdw1 /dev/sdg1 /dev/sdk1 /dev/sdj1 /dev/sdb1 /dev/sds1 /dev/sdn1 /dev/sdaa1

DATA mdadm aus /builds/mdadm

ydzq 4 xcu ac 8 rvp ab 12 fhaeoi

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdy1:1024 /dev/sdd1:1024 /dev/sdz1:1024 /dev/sdq1:1024 /dev/sdx1:1024 /dev/sdc1:1024 /dev/sdu1:1024 /dev/sdac1:1024 /dev/sdr1:1024 /dev/sdv1:1024 /dev/sdp1:1024 /dev/sdab1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sda1:1024 /dev/sde1:1024 /dev/sdo1:1024 /dev/sdi1:1024

47. Raid Recreate DATA und DATA2 2017-02-07

DATA2 mit normalem mdadm

lwgk 4 jbrm 8 aa

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdl1 /dev/sdw1 /dev/sdg1 /dev/sdk1 /dev/sdj1 /dev/sdb1 /dev/sdr1 /dev/sdm1 /dev/sdaa1

DATA mdadm aus /builds/mdadm

ydzp 4 xcu ac 8 qvo ab 12 fhaeni

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdy1:1024 /dev/sdd1:1024 /dev/sdz1:1024 /dev/sdp1:1024 /dev/sdx1:1024 /dev/sdc1:1024 /dev/sdu1:1024 /dev/sdac1:1024 /dev/sdq1:1024 /dev/sdv1:1024 /dev/sdo1:1024 /dev/sdab1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sda1:1024 /dev/sde1:1024 /dev/sdn1:1024 /dev/sdi1:1024

48. Raid Recreate DATA und DATA2 2017-02-24

DATA2 mit normalem mdadm

mwhl 4 kcsn 8 aa

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdm1 /dev/sdw1 /dev/sdh1 /dev/sdl1 /dev/sdk1 /dev/sdc1 /dev/sds1 /dev/sdn1 /dev/sdaa1

DATA mdadm aus /builds/mdadm

yezq 4 xdu ac 8 rvp ab 12 gibfoj

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdy1:1024 /dev/sde1:1024 /dev/sdz1:1024 /dev/sdq1:1024 /dev/sdx1:1024 /dev/sdd1:1024 /dev/sdu1:1024 /dev/sdac1:1024 /dev/sdr1:1024 /dev/sdv1:1024 /dev/sdp1:1024 /dev/sdab1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdb1:1024 /dev/sdf1:1024 /dev/sdo1:1024 /dev/sdj1:1024

49. Raid Recreate DATA 2017-03-24

Vormittags Server ganz aus. Dann Nachmittags hochgefahren, dabei sind 2 Platten "hängen geblieben" -> Data mit 2 fehlenden Platten clean but degraded

DATA mdadm aus /builds/mdadm

yezq 4 xdu ac 8 rvp ab 12 gibfoj

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdy1:1024 /dev/sde1:1024 /dev/sdz1:1024 /dev/sdq1:1024 /dev/sdx1:1024 /dev/sdd1:1024 /dev/sdu1:1024 /dev/sdac1:1024 /dev/sdr1:1024 /dev/sdv1:1024 /dev/sdp1:1024 /dev/sdab1:1024 /dev/sdg1:1024 /dev/sdi1:1024 /dev/sdb1:1024 /dev/sdf1:1024 /dev/sdo1:1024 /dev/sdj1:1024

50. Raid Recreate DATA und DATA2 2017-04-22

DATA2 mit normalem mdadm

lwgk 4 jbsn 8 aa

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdl1 /dev/sdw1 /dev/sdg1 /dev/sdk1 /dev/sdj1 /dev/sdb1 /dev/sds1 /dev/sdn1 /dev/sdaa1

DATA mdadm aus /builds/mdadm

ydzq 4 xcu ac 8 rvp ab 12 fhaeoi

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdy1:1024 /dev/sdd1:1024 /dev/sdz1:1024 /dev/sdq1:1024 /dev/sdx1:1024 /dev/sdc1:1024 /dev/sdu1:1024 /dev/sdac1:1024 /dev/sdr1:1024 /dev/sdv1:1024 /dev/sdp1:1024 /dev/sdab1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sda1:1024 /dev/sde1:1024 /dev/sdo1:1024 /dev/sdi1:1024

51. Raid Recreate DATA und DATA2 2017-05-09 nach USV-Alarm und Shutdown

29 Platten insgesamt

DATA2 mit normalem mdadm

lvgk 4 jbrm 8 z

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdl1 /dev/sdv1 /dev/sdg1 /dev/sdk1 /dev/sdj1 /dev/sdb1 /dev/sdr1 /dev/sdm1 /dev/sdz1

DATA mdadm aus /builds/mdadm

xdyp 4 wct ab 8 quo aa 12 fhaeni

./mdadm --create --assume-clean /dev/md125 --chunk=64 --level=raid6 --layout=ls --raid-devices=18 /dev/sdx1:1024 /dev/sdd1:1024 /dev/sdy1:1024 /dev/sdp1:1024 /dev/sdw1:1024 /dev/sdc1:1024 /dev/sdt1:1024 /dev/sdab1:1024 /dev/sdq1:1024 /dev/sdu1:1024 /dev/sdo1:1024 /dev/sdaa1:1024 /dev/sdf1:1024 /dev/sdh1:1024 /dev/sda1:1024 /dev/sde1:1024 /dev/sdn1:1024 /dev/sdi1:1024

52. Raid Recreate DATA und DATA2 2017-05-12

29 Platten insgesamt

DATA2 mit normalem mdadm

lwgk 4 jbrm 8 aa

mdadm --create --assume-clean /dev/md126 --chunk=64 --level=raid6 --layout=ls --raid-devices=9 /dev/sdl1 /dev/sdw1 /dev/sdg1 /dev/sdk1 /dev/sdj1 /dev/sdb1 /dev/sdr1 /dev/sdm1 /dev/sdaa1

DATA mdadm aus /builds/mdadm

ydzp 4 xcu ac 8 qvo ab 12 fhaeni